Le Keypoint 1+ vient de s’achever et il a été question de beaucoup de choses dont les RFI qui préoccupent tout le monde – les articles précédents du blog ont montré quelques instantanés très peu rassurants.

Et bien justement parlons un peu des RFI du point de vue de notre processeur L2, de nos algorithmes, de leurs validations et des ajustements et autres réglages que nous devons faire pendant cette phase de commissioning. La première chose qui vient à l’esprit c’est que notre méthodologie supposait une Terre assez propre. En effet, une part de cette validation repose sur la recherche d’un ensemble de points sur la surface qui satisfont certains critères comme l’homogénéité ou non de la surface, des variétés textures ,de couvertures de végétation ,et d’une manière générale, toutes les configurations que l’on souhaite utiliser pour activer et régler le comportement de nos algorithmes. Si l’on en reste là, il y a fort à parier que nos efforts seront ruinés tant les risques sont grands de tomber au final sur des zones inexploitables car trop contaminées par les RFI.

Il nous donc faut impérativement associer à cette sélection une carte qui décrit la qualité de la surface en terme d’occurence de RFI afin de choisir des endroits propres. Par chance, par vista ou finalement simplement par bon sens, c’est un aspect que nous avons prévu de gérer très tôt dans la conception de l’ATBD afin de retirer les observations qui seraient hors des gammes attendues afin de ne pas perturber l’inversion des paramètres, mais aussi pour de tenir compte cette information en entrée de nos traitements et de l’utiliser de façon interne dans nos métriques.

Pour rappel, les algorithmes du L2 considèrent deux classes de RFI:

- Les “Hard RFI”, dont la détection est aiséeet qui se base sur la radiométrie observée; ils s’agit simplement de repèrer les TBxx et les TByy qui sont supérieures à un seuil qui vaut aujourd’hui 340K. Nous détectons également les couples polarisation de TB issus de snapshots adjacents qui auraient une amplitude trop élevée i.e. Sqrt(TBxx²+TByy²) > 500K.

- les “Soft RFI”, qui n’ont pas de niveaux éxagérés et sont donc plus insidieuses car moins faciles à détecter. Deux critères sont utilisés ici. Le premier porte sur la faible dépendance théorique du premier coefficient de Stokes à l’angle d’incidence jusqu’à 45°-50° lorsque la surface à un émissivité de type Fresnel. De façon analogue à l’amplitude, des coules sont formés pour calculer une série de ST1=1/2(TBxx+TByy) afin de calculer le demi Stokes moyen <ST1>. Des lors, toute paire de TB dont le ST1 s’écarte de <ST1> de plus de 5K + 4 fois l’incertitude radiométrique de l’une des composantes se voit éliminé. D’une façon analogue, le deuxième test concerne les observations marginales qui sont trop éloignées du modèles après inversion; toute TB observée qui sécarte de plus de 4 fois son incertitude radiométrique de la TB modélisée associée est considérée comme suspecte et donc retirée de la liste des TBs.

Ainsi, à chaque inversion d’une demi orbite, le nombre de TB éliminées par les critères ci dessus pour chaque DGG traité est renseigné dans l’UDP; en fait on sépare les contribution dans chaque polarisation via les compteurs: N_RFI_X et N_RFI_Y. Cet UDP est utilisé par le post-processeur pour mettre à jour une carte globale de RFI – la DGG_CURRENT_RFI ou OPER_AUX_DGGRFI dansle jargon opérationnel – qui contient essentiellement trois valeurs, N_SNAP, N_RFI_X et N_RFI_Y. Cette mise à jour est fort simple et consiste, pour chaque DGG de l’UDP, à ajouter son champ MAVA0 (nombre de TB observées en ce point) au champ N_SNAP de son homologue dans la carte DGGRFI et de faire la même chose pour les N_RFI_X et N_RFI_Y.

Si l’on regarde au fil du temps un DGG particulier, sur terre, la valeur de N_SNAP va toujours augmenter au fur et à mesure que les fauchées de SMOS voient ce point et, éventuellement, les N_RFI_X et N_RFI_Y peuvent également augmenter si des perturbations sont détectées. Les cartes DGGRFI accumulent donc dans le temps pour chaque DGG le nombre de d’observations et le nombre d’événements RFI détectés parmi elles: P = (N_RFI_X + N_RFI_Y) / N_SNAP définit alors la probabilité d’avoir des RFI régulièrement détéctée pendant la période d’accumulation. Lorsque P vaut 1 pour un DGG donné, alors aucune des TBs qui ont observé ce DGG pendant dans la période n’a été conservée; 0.5 la moitié à été conservé et 0 toutes les TBs se sont avérées satisfaisantes du point de vue de nos critères.

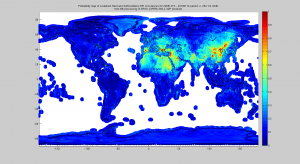

Ainsi, des cartes de RFI globales journalières sont crées automatiquement en opérationnel depuis que le processeur L2 a été activé le 07 décembre 2009. Ci contreon peut voir celle du 12 Janvier 2010 ou plus précisément la probabilité P calculée à partir de ses compteurs qui ont été présentés au dessus. Cette carte accumule un peu plus de 300 demi orbites traitées, soit une dizaine de jours.

Cette carte est terrifiante ! mais heureusement partiellement fausse, comme nous allons le voir ci après. Heureusement … car dans ces conditions trouver des points pour faire notre validation et réglages algorithmiques serait extrêmement ardu.

Cependant, on y retrouve les acteurs principaux qui polluent allègrement la bande-L qui apparaissent néanmoins à leur place. Elle fausse ? oui, sans aucun doute il y’a un problème dans l’implémentation du post-processeur que l’on va devoir éliminer (c’est en cours). Par exemple, l’Antarctique est une zone que l’on a constaté très propre, même avec les L1C du DPGS. On observe ci contre un niveau de probabilité dans les 0.4, ce qui signifie que l’on a retiré 40 % des TBs dans la période de temps. Même en admettant que ce type de surface n’est pas bien “Fresnelienne” et donc susceptible sans doute de générer des outliers par échec de notre modélisation, ce n’est quand même pas très cohérent.

Alors “let’s do it ourself” et calculons ces cartes de RFI accumulées; c’est très simple à faire. En revanche comme ce n’est vraiment intéressant que sur une période temps qui accummule suffisament d’orbites pour bien “peindre’ toute la Terre et donner un sens plus robuste au calcul de P. Nous allons donc utiliser les UDPs du DPGS basés sur les L1C du DPGS. Nous savons d’ores et déjà que la qualité sera meilleure dès que le DPGS mettra en oeuvre les derniers réglages du L1PP ainsi que les dernières calibrations (sans doute d’ici 15 jours). Mais c’est pas grave et ce sera comparable à celle de l’exemple précédent.

Cette fois il y’a du changement … et dans le bon sens. La carte devient plus contrastée, les sources sont toujurs à leurs places, mais l’optismisme grimpe en flêche quant à la possibilité de trouver des zones exploitables. Evidement, nos gros pollueurs sont toujours bien là, mais leurs localisations comme source intiales des bavures bien plus précises. L’intérêt de ces cartes est leur coté statistique … quand un point est rouge ( proba = 1) ce n’est pas un coup de malchance ou une réalité transitoire, c’est de la pollution continue.

Bien que le niveau sur l’Antarctique ait significativement baissé il reste néamoins relativement haut. L’hypothèse évoquée précédement d’outliers décrivant une fausse alarme RFI pour ce type de surface peu prendre du sens et pusique l’on traite manuellement les données alors on peut aussi s’intéresser au DAP. En effet, celui ci contient un champ qui nous intéresse, c’est N_CLEANED. C’est un compteur, qui (normalement) compte justement les outliers que nous avons retirés et que l’on ajouté dans les compteurs de RFI.

Nous allons donc retirer les ouliers via N_CLEANED pour ne considérer les probabilités de RFI détéctées uniquement sur la base de l’observation radiométrique. Calculons P’=(N_RFI_X+N_RFI_Y-N_CLEANED )/N_SNAP, ce qui nous donne la carte ci contre. Les zones de glaces profondes Antarctique et Alaska mais également les

forêts denses se sont assombries vers le bleu foncé et parallèlement l’Afrique centrale est vue comme plus exploitable – bon à ce stade difficile de savoir si c’est plus raisonnable ou pas, mais cela donne un aspect plus rayonnant sur le axes d’orbites des beamers principaux, Espagne, Grèce et le Golfe et bien sûr Asie et Chine.

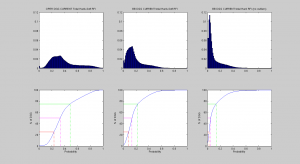

Une façon simple de mesurer l’augmentation de contraste entre ces trois traitements c’est de calculer leurs histogrames et fonctions de répartition. Si l’on considère la barre verte qui représente 75% des DGGs nous passons d’une proba de 0.49, 0.21et finalement 0.12, ce qui signifie pour cette dernière qu’il existe 75% des points dont on retire au maximum 1 TB / 10 en moyenne sur les 11 jours considérés.

Il y’a de quoi retrouver un peu le sourire lorsque l’on intégre dans le temps cette problématique de RFI et nous allons pouvoir avancer. Malgré tout il faut garder à lesprit que parfois on perdra des séquences quand les orbites ne seront pas favorables. Un point intéressant avec ces cartes de DGGRFI c’est que l’on peut facilement régler la fenêtre temporelle d’analyse et le momment – il suffit simplement de considérer les deux dates et de soustraire les ompteurs de la plus ancienne au compteurs de la date la plus récente et de calculer les probabilités souhaitées sur cette différence.

One thought on “Les RFI dans la bande protégée des 21cm (bande L) vues par le SML2PP”